新的人工智能诞生了,它便是阿尔法元AlphaGo Zero。在对阵曾赢下韩国棋手李世石那版的AlphaGo时,AlphaGo Zero取得了100比0的压倒性战绩,这真是棋艺高超啊……

围棋之神真来了

文|体坛周报记者 谢锐

比Alpha Go还要厉害得多的人工智能诞生了,它便是阿尔法元Alpha Go Zero。在10月19日世界《自然》杂志上线的重磅论文中,详细介绍了谷歌DeepMind团队最新的研究成果。

阿尔法元完全从零开始,不需要任何历史棋谱的指引,更不需要参考人类任何的先验知识,完全靠自己强化学习和参悟, 棋艺增长远超阿尔法狗,百战百胜,击溃阿法尔狗100比0。

2016年3月,第一次“人机大战”,Alpha Go1.0版4比1击败14个世界冠军获得者李世石九段;

年底,Alpha Go升级版化身Master在网上对人类高手60连胜,震惊棋界。2017年5月第二次“人机大战”,Alpha Go2.0版3比0胜柯洁九段,此后宣布不再与人对弈。

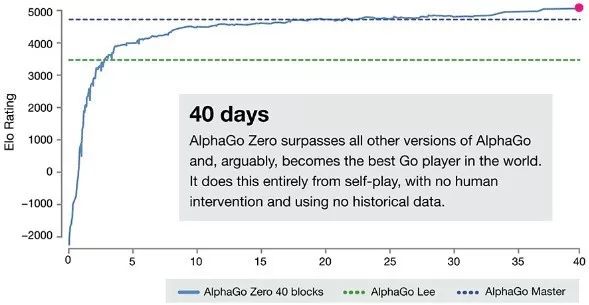

但阿尔法狗团队并未停止研究,现在研究出来的成果是Alpha Go Zero。与阿尔法狗不同,阿尔法元不再学习人类棋谱,而是在掌握基本规则后,通过左右互博,仅仅40天时间,即成为碾压Master的人工智能。

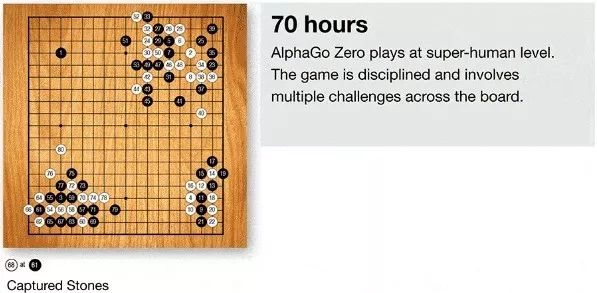

美国的两位棋手在《自然》杂志对阿尔法元的棋局做了点评:它的开局和收关与职业棋手的下法并无区别,这说明,人类在围棋上几千年的智慧结晶,看起来并非全错,阿尔法元的中盘看起来则非常诡异,着法比阿尔法狗左右互搏时使出的怪招更加不可思议。按照时越九段的话说就是,来自未来的着法。

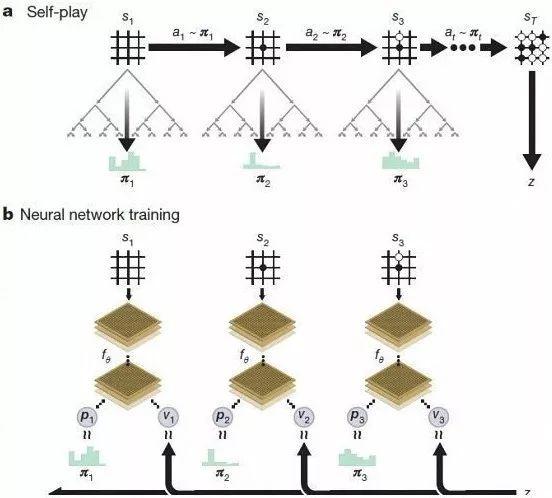

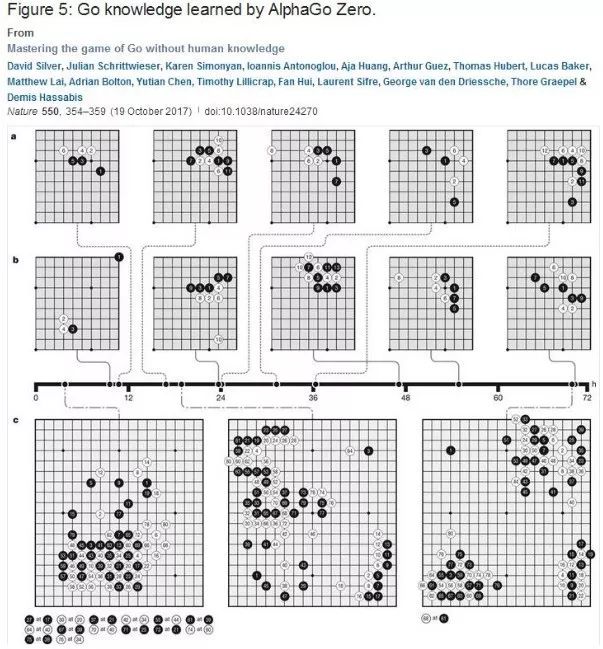

Alpha Go Zero之所以能当自己的老师,是用了一种叫强化学习的新模式。系统从一个对围棋一无所知的神经网络开始,将该神经网络和一个强力搜索算法结合,自我对弈。

在对弈过程中,神经网络不断调整、升级,预测每一步落子和最终的胜利者。升级后的神经网络与搜索网络结合成一个更强的新版本Alpha Go Zero,如此往复循环。每过一轮,系统的表现就提高一点点,自我对弈的质量也提高一点点。神经网络越来越准确,Alpha Go Zero的版本也越来越强。

这种技术比此前所有版本的Alpha Go都更为强大。这是因为,它不再受到人类知识的限制,而能够从婴儿般的白纸状态,直接向世界上最强大的棋手——Alpha Go本身学起。

因为这些改进,Alpha Go Zero的表现和训练效率都有了很大的提升,仅通过4块TPU和72小时的训练就胜过之前训练用时几个月的原版Alpha Go。自我对弈40天后,Alpha Go Zero变得更为强大,超过了此前击败当今围棋第一人柯洁的Master亦即Alpha Go2.0版。

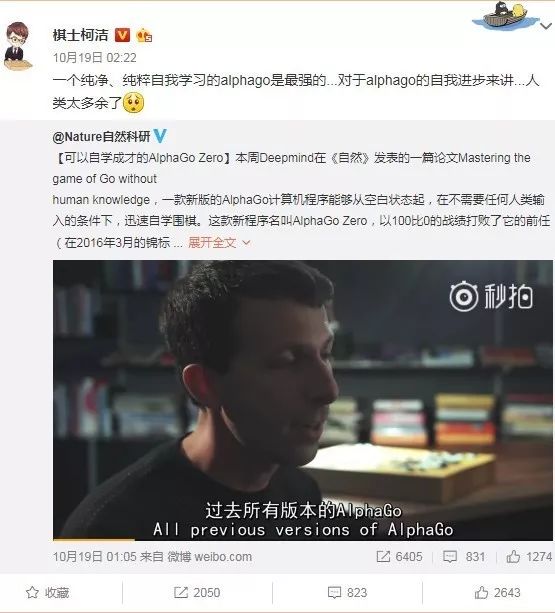

柯洁发微博:“一个纯净、纯粹自我学习的alphago是最强的……对于Alphago的自我进步来讲,人类太多余了。”Alpha Go通过数百万次自我对弈,从零开始掌握围棋,在短短几天内积累人类几千年才有的知识。Alpha Go Zero也发现了新的知识,发展出打破常规的策略和新招,与它在对战李世石和柯洁时创造的那些交相辉映,却又更胜一筹。

不过,这些创造性的时刻给了我们信心:人工智能会成为人类智慧的增强器,帮助我们人类解决人类正在面临的一些严峻挑战。尽管才刚刚发展起来,但是Alpha Go Zero已经走出了通向上述目标的关键一步。如果类似的技术可以应用在其他结构性问题,比如蛋白质折叠、减少能耗和寻找新材料上,就能创造出有益于社会的突破。

比阿尔法狗(Alpha Go)更为强大和进步更快的阿尔法元(Alpha Go Zero)诞生后,围棋界再次被震撼,古力九段发微博:“20年不抵3天啊!我们的伤感,人类的进步!”

阿尔法元通过自学成为围棋第一高手,其下法固然颠覆了人类棋谱、棋路,但人类还是能看懂,而且其有套路可循。其执黑第一手还是星位,然后直接点对方星位角的三、三,这也是目前棋手们几乎公认的下法。

比起当初Master在布局一些诸如四路肩冲、六路跳起的惊世骇俗下法,如今阿尔法元在技术上给人类造成的冲击还不如Master,但其40天时间里从一张白纸到碾压Master的高手,这样的成长速度才令人类震惊不已。

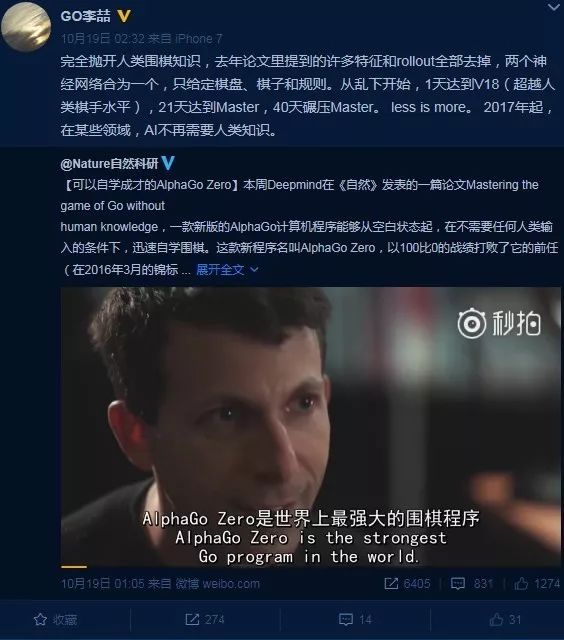

李喆六段发微博:“完全抛开人类围棋知识,去年论文里提到的许多特征和rollout全部去掉,两个神经网络合为一个,只给定棋盘、棋子和规则。从乱下开始,1天达到V18(超越人类棋手水平),21天达到Master,40天碾压Master。2017年起,在某些领域,AI不再需要人类知识。”

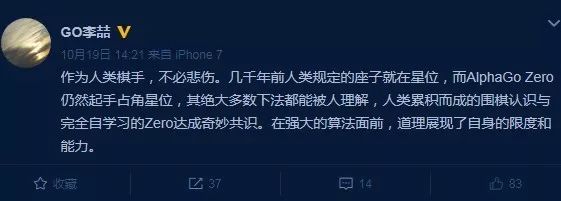

紧跟这条微博之后,李喆又发了条有关阿尔法元的微博:“作为人类棋手,不必悲伤。几千年前人类规定的座子就在星位,而Alpha Go Zero仍然起手占角星位,其绝大多数下法都能被人理解,人类累积而成的围棋认识与完全自学习的Zero达成奇妙共识。在强大的算法面前,道理展现了自身的限度和能力。”

阿尔法元从零起步学习围棋,完全脱离人类既有围棋理论和知识的局限,通过强大的自我学习功能达到第一高手水准,但它的一些布局思路与人类几千年来的智慧成果殊途同归,这也证明人类围棋理论的科学性、合理性,并不完全是“糟粕”。

现在问题来了,Alpha Go Zero诞生后,职业棋手以及围棋培训的路是不是已走到尽头?人工智能专家、美国北卡罗莱纳大学夏洛特分校教授洪韬认为没必要这么悲观,“上世纪八九十年代,人工神经网络的研究迎来了一场大火,学术圈发了成千上万篇关于神经网络的论文,从设计到训练到优化再到各行各业的应用,最后不了了之。”

美国密歇根大学人工智能实验室主任Satinder Singh也表达了类似观点:这并非任何结束的开始,人工智能和人甚至动物相比,所知所能依然极端有限。

其实,阿尔法狗也好,阿尔法元也罢,哪怕它们的着法接近围棋之神,但它们终究没有感情、没有个性,不会弈出“宇宙流”这样充满魅力个性的棋来。他们的确精确,但不见个性、不见失误,因而激不起人类的喜乐哀愁,少了无数乐趣。

Alpha是希腊字母表中的第一个字母α,表示“第一个,最初,开端”,而Go则是源于日语中围棋的发音,罗马注音为“go”,和英语“go”的读音略有差异。虽然围棋起源于中国,但是日本对它的推广有极大贡献,所以国际围棋的术语多来自日语。

在一个完全可以不走寻常路的年代,只走寻常路的翻译常常会让人感到别扭。

又到了各位脑洞大开的时刻:

某位网友说,应该叫“阿尔法狗”。

对桌同事说,应该叫“阿尔法我去”。

隔壁老王说,应该叫“阿尔法我们走”。

某位不知名人士透露,应该叫“阿尔法走你”。

当然还有人,也就是小编觉得“阿尔法围棋”这个译法,的确似乎应该还是更符合规矩一点。

实习编辑|小赞